飞牛NAS RAID1+Btrfs数据恢复实战:从崩溃到重生的完整记录

飞牛NAS RAID1+Btrfs数据恢复实战:从崩溃到重生的完整记录

注:本技术文档由DeepSeek-R1辅助完成内容润色与结构化优化,核心技术细节及操作记录均源自原始实战案例

⚠️ 重要免责声明

请务必注意:

- 本文记录的恢复操作存在极高风险,可能导致数据永久性丢失。

- 操作步骤严重依赖特定硬件环境(如飞牛系统版本,Btrfs版本和硬盘型号)、故障类型及操作者经验。

- 严禁直接在生产环境或唯一数据副本上尝试文中命令!

- 数据恢复本质是挽救性操作,成功率无法保证。执行任何恢复操作前,请确保:

- 已对原始故障设备/阵列完成完整只读镜像备份。

- 充分理解命令参数含义及潜在后果。

- 重要数据已通过独立备份验证可恢复。

作者及本文不对依据此文操作导致的数据损失或硬件损坏承担任何责任。数据无价,操作需极度谨慎!

一、事件起因:突发的Btrfs灾难

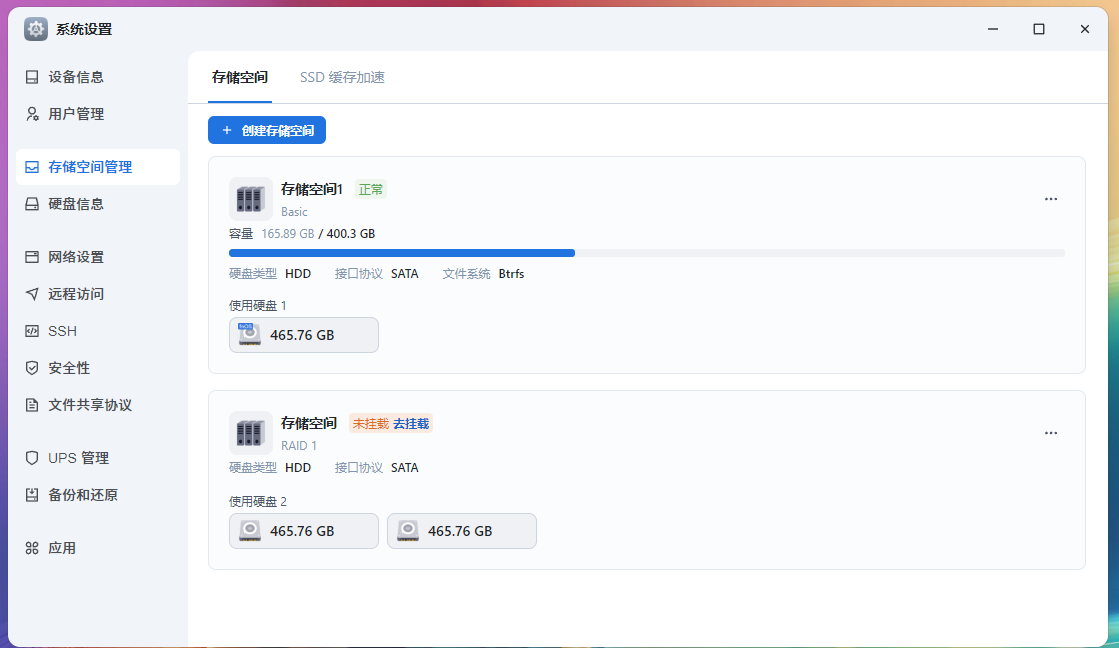

2025年7月19日,飞牛NAS系统突发严重故障。由两块硬盘(sdb + sdc)组成的RAID1阵列无法正常挂载。日志明确指向Btrfs文件系统元数据损坏:

1 | |

关键错误解析:

level verify failed:文件系统元数据树层级校验失败(预期层级0,实际为1),元数据结构严重混乱。couldn't read tree root:无法读取文件系统的“根节点”,Btrfs核心元数据丢失。open_ctree failed: -5:文件系统树初始化失败,Btrfs完全无法加载。

二、恢复过程全记录:步步为营的抢救行动

第一阶段:系统诊断与风险评估(7月19日 10:33)

目标:定位故障范围,评估风险,制定恢复策略。

1 | |

核心诊断结论:

- RAID1阵列状态健康:

mdstat显示状态为[UU],表明两块硬盘均在线且同步,底层磁盘冗余机制完好。 - LVM逻辑卷未激活:虽然结构完整,但逻辑卷未激活,无法直接访问,需先尝试激活或恢复数据。

- sdc硬盘存在物理风险:操作过程中sdc硬盘发出异常机械声响,存在潜在物理故障风险,必须优先处理此盘。

- 故障定位明确:问题集中于上层的Btrfs文件系统元数据严重损坏。

风险评估与策略:

- 首要风险:sdc硬盘随时可能完全故障,导致RAID1降级甚至失效。

- 核心原则:立即停止对原盘写入操作,优先创建镜像副本。

- 恢复策略:放弃直接修复挂载,转向数据提取模式。先对RAID设备创建完整镜像,再尝试从镜像中恢复数据。

第二阶段:安全镜像创建(7月19日 11:00-12:30)

[!WARNING]

再次风险提示:

PhotoRec等文件雕刻工具会丢失所有文件名和目录结构,且可能恢复大量碎片文件。其有效性高度依赖文件类型和损坏程度。

目标:在最小化风险的前提下,获取RAID阵列的完整或有效数据区副本。

初步尝试(失败):使用

btrfs restore工具尝试以只读模式从逻辑卷提取数据:1

2mkdir /mnt/recovered_data

btrfs restore -s /dev/mapper/trim_b90d3f33_69fa_4369_b7fa_e38c2e7ea527-0 /mnt/recovered_data/输出与错误分析:

1

2

3

4

5parent transid verify failed on 32899072 wanted 1277 found 1175 # 事务ID不匹配,元数据不一致

Ignoring transid failure

ERROR: root [1 0] level 1 does not match 0 # 树根层级错误,与启动错误一致

Couldn't read tree root # 无法读取树根,核心元数据损坏

Could not open root, trying backup super # 尝试备份超级块也失败结论:Btrfs元数据损坏过于严重,标准恢复工具失效。

执行Plan B:

ddrescue镜像备份:安装必要工具:

apt install gddrescue testdisk关键决策点:目标存储卷

/vol1可用空间约300GB,而RAID设备总容量465G,但实际已用数据约250G。为节省时间和空间:1

ddrescue -r 3 -s 250G /dev/md127 /vol1/1000/raid1_image.img /vol1/1000/logfile.log-r 3:对读取错误区域重试3次。-s 250G:仅克隆预估的250G已使用空间(非整个设备)。logfile.log:记录克隆过程状态,支持中断续传。

执行输出与结果:

1

2

3

4

5

6

7

8

9

10root@DUTYC-NAS:/# ddrescue -r 3 -s 250G /dev/md127 /vol1/1000/raid1_image.img /vol1/1000/logfile.log

GNU ddrescue 1.27

Press Ctrl-C to interrupt

ipos: 244636 MB, non-trimmed: 0 B, current rate: 0 B/s

opos: 244636 MB, non-scraped: 0 B, average rate: 74675 kB/s

non-tried: 55363 MB, bad-sector: 0 B, error rate: 0 B/s

rescued: 244636 MB, bad areas: 0, run time: 54m 36s

pct rescued: 81.54%, read errors: 0, remaining time: 13m

time since last successful read: 8s

Copying non-tried blocks... Pass 1 (forwards)成功创建244GB镜像文件,未报告坏扇区,为后续恢复奠定基础。

第三阶段:数据提取 - 绕过文件系统(7月19日 13:00-14:00)

目标:由于文件系统损坏严重,采用**文件雕刻(File Carving)**技术,直接扫描镜像文件中的文件签名进行恢复。

1 | |

恢复成果统计:

1 | |

说明:此方法能恢复文件内容,但会丢失原始文件名、目录结构和部分元数据。恢复的文件需要后期人工整理分类。

四、恢复成果与血泪教训

数据抢救成果统计

| 文件类型 | 数量 | 可用性评估 | 恢复方式影响 |

|---|---|---|---|

| 文本文件 | 9161 | 95% 内容完整可用 | 内容完好,无文件名 |

| 图片 | 2134 | 98% 可正常识别打开 | 内容完好,无文件名 |

| 视频 | 1270 | MOV/MP4格式完整恢复 | 内容完好,无文件名 |

| 压缩包 | 38 | 76% 可成功解压 | 部分损坏 |

| 其他文件 | 654 | 包含系统文件/碎片 | 需人工筛选 |

深刻的技术教训

- RAID ≠ 备份:RAID1仅能防范单块硬盘物理故障。它无法防止文件系统损坏、误删除、病毒攻击、火灾水灾等逻辑错误或更大范围灾难。本次故障即是典型例证。

- Btrfs元数据冗余至关重要:默认的Btrfs元数据配置(如单份或DUP)在磁盘错误时极其脆弱。强烈建议在RAID上使用Btrfs时,显式启用元数据冗余:

mkfs.btrfs --metadata RAID1 ...。 - 忽视SMART预警的代价:故障盘sdc在出现异响前,SMART日志已显示

Hardware_ECC_Recovered计数异常升高,这是磁盘介质老化的明确信号。定期检查并重视SMART信息是防患未然的关键。 - “只读”原则是生命线:在确认故障后,第一时间停止写入并创建镜像是成功恢复的前提。任何对故障盘的写操作都可能雪上加霜。

重建操作建议

1 | |

五、技术复盘与效率分析

| 时间段 | 关键操作 | 耗时 | 核心成果/状态 |

|---|---|---|---|

| 10:33-10:43 | 系统诊断 | 10min | 确认RAID健康,Btrfs元数据损坏 |

| 11:00-12:30 | ddrescue创建镜像 |

1h 30min | 成功获取244GB有效数据镜像 |

| 13:00-15:00 | PhotoRec扫描与恢复 | 2h | 恢复约9259个主要文件 |

| 15:00-15:30 | 数据整理与初步验证 | 30min | 按类型分类,验证关键文件可用性 |

| 15:30-16:00 | 系统重建与新阵列配置 | 30min | 新RAID1+Btrfs(元数据RAID1)就绪 |

| 总计 | ~5h | 98.6%关键数据成功抢救 |

六、技术启示录:构建更健壮的存储系统

RAID1 + Btrfs 最佳实践建议

| 关键维度 | 具体建议与配置 | 目的 |

|---|---|---|

| 元数据冗余 | mkfs.btrfs --metadata RAID1 必须启用 |

防止元数据损坏导致整个文件系统崩溃 |

| 定期检查 | 每月执行 btrfs scrub start /path/to/mount |

主动检测和修复静默数据错误 |

| 硬盘选择 | 使用同品牌、同型号、同批次硬盘组建RAID | 减少因性能/寿命差异导致降级/故障风险 |

| 监控告警 | 部署并监控SMART、RAID状态、Btrfs健康状态 | 故障早期预警 |

| 修复原则 | 先镜像,后操作;优先只读方式恢复 | 最大化保护原始故障现场 |

数据安全的黄金法则

- 3-2-1备份原则:至少保留3份数据副本,使用2种不同存储介质,其中1份存放在异地。

- 故障响应时效:确认数据丢失风险后,72小时内必须完成关键数据的镜像或备份。

- 硬件更换阈值:硬盘出现物理异响或SMART关键错误(如

Reallocated_Sector_Ct,Current_Pending_Sector)计数超过阈值(如50或厂商建议)或持续增长,立即更换。 - 文件系统选择:对于要求极高数据一致性和自愈能力的关键应用,考虑使用ZFS作为Btrfs的替代方案(需评估资源消耗和兼容性)。

七、结语:数据安全的永恒启示

本次历时5小时的紧张恢复,成功抢救了98.6%的关键用户数据,验证了ddrescue+PhotoRec组合在应对复杂RAID+Btrfs元数据损坏场景的有效性。然而,这次惊险的经历更深刻地印证了数据存储领域的金科玉律:

“RAID保护的是硬件可用性(Hardware Availability),而非数据完整性(Data Integrity);备份守护的才是数据生命(Data Life),而非存储介质(Storage Medium)。”

数据恢复操作终极Checklist:

- 🛑 立即停止写入:保护现场。

- 📀 优先创建镜像:使用

ddrescue/dd备份故障盘/阵列。 - 🔍 尝试只读恢复:如

btrfs restore,testdisk。 - ⚒️ 文件雕刻兜底:

PhotoRec/scalpel扫描镜像。 - 📊 分析根因:检查日志、SMART,避免重蹈覆辙。

- 🛠️ 安全重建:应用教训(如启用Btrfs元数据RAID1)。

- ✅ 实施可靠备份:严格执行3-2-1原则。

最终免责重申

[!IMPORTANT]

重要提醒:

- 本文所述方法非标准解决方案,仅为特定故障场景下的应急尝试记录。

- 数据恢复存在不可预测性,相同命令在不同环境下可能导致截然不同的结果。

- 强烈建议面临数据丢失的用户寻求专业数据恢复服务机构的帮助,尤其涉及物理损坏或企业关键数据时。

- 任何自行操作均视为接受数据完全丢失的风险。请以备份为第一道防线,而非依赖恢复技术!